AI ストレージの進歩におけるソリダイム SSD の役割

人工知能が人類の願望を刺激するために急速に進歩するにつれて、コンピューティング能力も成長しなければなりませんでした。 高スループット、低レイテンシー・ネットワーク、ディープラーニングモデルに支えられ、あらゆる場所で数千の GPU クラスターが出現しています。 この進化する市場は、AI アーキテクトの深い熟考を促します。 最も重要な質問の 1 つは、アイドルタイムなしに、AI アクセラレータ (GPU、CPU など) とネットワークデバイスをフル容量で動作させることができる AI ストレージ・インフラストラクチャーとはどのようなものなのか、ということです。

Phases of an AI project cycle

業界慣行の分析では、一般的な AI プロジェクト・サイクルは以下の 3 つの主要なフェーズで構成されていることが明らかになっています。

- データのインポートと準備

- モデル開発 (トレーニング)

- モデル導入 (推論)

第 4 フェーズ(任意)は、実際の推論結果と新しいデータに基づいてモデルの反復的改良を伴う場合があります。AI のストレージ要件を理解するには、各フェーズにおける第一次入出力 (I/O) 操作の性質を理解し、それらを総合的に検討して包括的なビューを形成することが不可欠です。

フェーズ 1: データ取り込みと準備

トレーニングに飛び込む前に、トレーニング・クラスターに送り込まれるデータを徹底的に準備することが重要です。

1. データの変換: 発見、抽出、前処理

AI モデルの作成に使用される生データは、ボリューム (Volume)、速度 (Velocity)、多様性 (Variety) という、伝統的なビッグデータの特徴である「3V」を継承しています。データのソースは、イベントログ、トランザクション記録、IoT 入力から CRM、ERP、ソーシャルメディア、衛星画像、経済、株式取引までさまざまです。これらの多様なソースからデータを抽出し、データ・パイプライン内の一時的なストレージ領域に統合する必要があります。このステップは、通常"抽出"と呼ばれます。

データは、さらなる分析に適したフォーマットに変換されます。元のソース・システムではデータは混沌としており、解釈が困難です。変換の目的の一部は、データ品質を向上させることです。これらには、次のものが含まれます。

- 無効なデータのクリーンアップ

- 重複データの削除

- 単位の標準化

- 種類に基づいたデータの整理

変換フェーズでは、データは特定の業務目的に合わせて構造化され、再フォーマットされます。このステップは、"変換"と呼ばれます。

2. データ探索とデータセットの分割

データアナリストは、視覚化と統計技術を用いて、そのスケール、量、精度などのデータセットの特徴を記述します。調査を通じて、異なる変数、データセットの構造、異常性の存在、値の分布の関係を特定し調べます。データ探索により、アナリストは生データの奥深くまで掘り下げることができます。

明白なエラーを特定し、データ内のパターンをよりよく理解し、外れ値や異常事象を検出し、変数間の興味深い関係を明らかにする手助けとなります。データ探索が完了すると、データセットは、通常、トレーニングとテストのサブセットに分割されます。これらのサブセットは、トレーニングとテストの目的でモデル開発時に別々に使用されます。

3. 特徴抽出、特徴選択、パターンマイニング

AI モデルの成功は、選択した機能が研究における分類問題を効果的に表すことができるかどうかにかかっています。

例えば、チョイスの個々のメンバーを考えてみましょう。特徴には、性別、身長、肌の色、教育レベルなどが含まれます。

特徴として、以前の4つの次元とは異なり、声域を小さくすることで、寸法が合致する (データ量がかなり少ないことを意味する)、より正確なものとなる可能性が高くなります。

高次元の危険性を回避し、計算複雑さを減らすために、機能の次元を下げるために、最も効果的な特徴を特定するプロセスは特徴選択として知られています。

特徴配列の中で、どのものが互いに排他的であるか、共存するかといった、それらの本質的な関係と論理を明らかにするプロセスはパターンマイニングと呼ばれています。

4. データ変換

さまざまな理由により、データを変換する必要が生じる場合があります。 これは、あるデータを他のデータと調整する、互換性を促進する、データの一部を別のシステムに移行する、他のデータセットとの接続を確立する、またはデータ内の情報を集約するという要望によって引き起こされる可能性があります。

データ変換の一般的な側面には、タイプの変換、セマンティクスの変更、値の範囲の調整、粒度の変更、テーブルまたはデータセットの分割、行と列の変換などが含まれます。

成熟したオープンソース・プロジェクト・コミュニティのおかげで、データの取り込みと準備の段階で自由に使える信頼性の高いツールが豊富にあります。 これらのツールを使用すると、ETL (抽出、変換、ロード) または ELT (抽出、ロード、変換) タスクを実行できます。例としては次のものが挙げられます。

- Kafka

- Sqoop

- Flume

- Spark

- Nifi

さらに、多数の機能セットの作成などのタスクでは、次のようなツールを活用することができます。

- Spark

- Pandas

- Numpy

- Spark MLLib

- scikit-learn

- XGBoost

5. データ取り込みと準備フェーズに適したストレージの特性

データ取り込みと準備フェーズでは、典型的なワークフローは、データをランダムに読み込み、処理されたアイテムをシーケンシャルに書き込むことです。ストレージ・インフラストラクチャーにとって、小さなランダムリードに低レイテンシーを提供しながら、同時に高いシーケンシャル・ライト・スループットを達成することが不可欠です。

フェーズ 2: モデル開発とトレーニング

トレーニングデータセットの準備が完了すると、次のフェーズはモデル開発、トレーニング、ハイパーパラメータのチューニングです。アルゴリズムの選択はユースケースの特性によって決定され、モデルはデータセットを使用して訓練されます。

1. AI のフレームワーク

モデルの効率は、テストデータセットに対して評価され、必要に応じて調整され、最終的に導入されました。AI フレームワークは、以下の一般的なフレームワークで継続的に進化しています。

- TensorFlow

- PyTorch

- MXNet

- Scikit Learn

- H2O

- その他

この段階では、計算リソースに対する要求が非常に高くなります。これらのリソースにデータをより速く、より効率的に供給することが、リソースのアイドル状態を排除する優先事項となるため、ストレージは重要です。

モデル開発中、データセットは継続的に拡大し、多くの場合、多数のデータ・サイエンティストが異なるワークステーションから同時にアクセスする必要があるため、過学習を防ぐために数千ものバリエーションのエントリを動的に増強します。

2. ストレージ容量の拡張性とデータ共有

この段階ではストレージ容量が重要になり始めますが、同時データアクセス操作の数が増えるにつれて、スケーラブルなパフォーマンスが成功の鍵となります。ワークステーションとサーバー間のデータ共有は、迅速かつシームレスな容量拡張とともに、不可欠なストレージ機能です。

トレーニングが進むにつれて、データセットのサイズは増加し、多くの場合数ペタバイトに達します。各トレーニング・ジョブには通常、ランダムリードが関与し、プロセス全体は同じデータセットにアクセスする多数の同時ジョブで構成されます。データアクセスを競合する複数のジョブが、全体的なランダムI/Oワークロードを集中します。

モデル開発からトレーニングへの移行には、数十億のデータアイテムを収容するために中断することなく拡張できるストレージが必要です。また、高速なマルチホストのランダムアクセス、特に高いランダム読み取りパフォーマンスも必要です。

トレーニングジョブでは、多くの場合、入力データの圧縮解除、入力データの増強または摂動、入力順序のランダム化が行われ、特に数十億のアイテムのコンテキストでは、トレーニングデータ項目のリストのストレージをクエリするためにデータ項目の列挙が必要になります。

3. チェックポイントの作成: 大規模シーケンシャルライトのバースト

トレーニングの規模が膨大になると、新たな要求が生じます。今日におけるトレーニングジョブは、数日から場合によっては数か月にわたって実行される場合があります。そのため、ほとんどのジョブは、障害から迅速に回復するために定期的なチェックポイントを書き込むことで、最初から再起動する必要性を最小限に抑えます。

したがって、トレーニング中の主なワークロードはランダムリードで構成されますが、チェックポイント中の大規模なシーケンシャルライトによって中断される場合があります。ストレージシステムは、チェックポイント作成中の大規模なシーケンシャルライトのバースト中であっても、同時トレーニンジョブに必要な集中的なランダム アクセスを維持できる必要があります。

4. モデル開発フェーズのまとめ

要約すると、AI モデルの開発は高度に反復的なプロセスであり、連続した実験によって仮説が確認または反駁されます。モデルが進化するにつれて、データサイエンティストはサンプルデータセットを使用して、多くの場合数万回の反復を通じてモデルをトレーニングします。

反復ごとに、データ項目を増強し、過学習を防ぐためにわずかにランダム化して、トレーニングデータセットに対して正確でありながらライブデータにも適応できるモデルを作成します。トレーニングが進むにつれてデータセットが増大するため、データサイエンティストのワークステーションから、より優れた計算能力とストレージ能力を備えたデータセンターのサーバーへと移行が行われます。

フェーズ 3: モデル導入と推論

モデルの開発が完了したら、サービスをデプロイして運用を開始します。この推論フェーズでは、実世界のデータがモデルに入力され、理想的には、その出力によって貴重な洞察が得られます。 多くの場合、モデルは継続的に微調整されます。 推論段階でモデルにインポートされた新しい実世界データは再トレーニングプロセスに組み込まれ、パフォーマンスが向上します。

1. 実際のアプリケーションでの微調整

AI ストレージ・インフラストラクチャーは、プロジェクトのライフサイクル全体を通じて 24 時間シームレスに動作する必要があります。そのため、コンポーネントの障害を処理し、停止することなく拡張とアップグレードを可能にする自己修復機能を備えている必要があります。

データサイエンティストは、モデルを微調整し、変化するパターンと目標を調査するために本番データを必要としています。これは、プロジェクトのすべてのフェーズにサービスを提供する単一のストレージシステムである統合プラットフォームの重要性を強調しています。このようなシステムにより、開発、トレーニング、本番環境は動的に進化するデータに簡単にアクセスできます。

2. 実稼働に向けたモデルの準備

モデルが一貫して正確な結果を生成すると、そのモデルは実稼働環境にデプロイされます。その後、焦点はモデルの改良から堅牢な IT 環境の維持に移ります。制作には、インタラクティブまたはバッチ指向など、さまざまな形式があります。新しいデータを継続的に使用することは、モデルを改良して精度を高めるのに役立ち、データサイエンティストはモデルの出力を分析しながらトレーニングデータセットを定期的に更新します。

以下の表は、AI プロジェクト サイクルの各フェーズと、それぞれの I/O 特性と、それに伴うストレージ要件をまとめたものです。

| AI のフェーズ | I/O 特性 | ストレージ要件 | 影響 | データの取り込みと保存 | ランダムにデータを読み込み、前処理済みの項目を順次書き込む | 少ないランダムリードで低レイテンシー、高いシーケンシャル・ライト・スループット | 最適化されたストレージによりパイプラインがトレーニング用により多くのデータを提供でき、より正確なモデルにつながる | モデル開発 (トレーニング) | ランダムデータリード | マルチジョブのパフォーマンスと容量におけるスケーラビリティ、最適化されたランダムリード、チェックポイントのための高いシーケンシャル・ライト・パフォーマンス | 最適化されたストレージにより、高価なトレーニング・リソース (GPU、TPU、CPU) の使用率が向上 | モデル導入 (推論) | ランダムリード / ライトの混合 | コンポーネントの故障を処理する自己修復機能、破壊的ではない拡張とアップグレード モデルが継続的に微調整を行う場合はトレーニング段階と同じ機能 |

ビジネスには高い可用性、保守性、信頼性が求められる |

|---|

表 1. I/O 特性とその後のストレージ要件による AI プロジェクト・サイクル

AI 導入のための主要なストレージ特性

初期モデル開発時にはシングル・シャーシ・システムとして始まる AI プロジェクトは、トレーニング中にデータ要件が増加していくため、生産現場で蓄積されるライブデータが増えるにつれて、柔軟性を高める必要があります。 大容量を実現するために、インフラストラクチャーレベルでは、個々のディスク容量を増やすことと、ストレージ・エンクロージャーのクラスターサイズを拡張するという 2 つの重要な戦略が採用されています。

1. 容量 個々のディスクの容量を高め、ストレージ・ノードの水平なスケーラビリティを向上させることは重要な要素です。 ディスクレベルでは、ソリダイム D5-P5336 QLC SSD などの製品では、最大 61.44TB の容量に達しています。 ストレージ・エンクロージャレベルでは、 EDSFF (Enterprise and Datacenter Standard Form Factor) が比類のないストレージ密度を示しています。

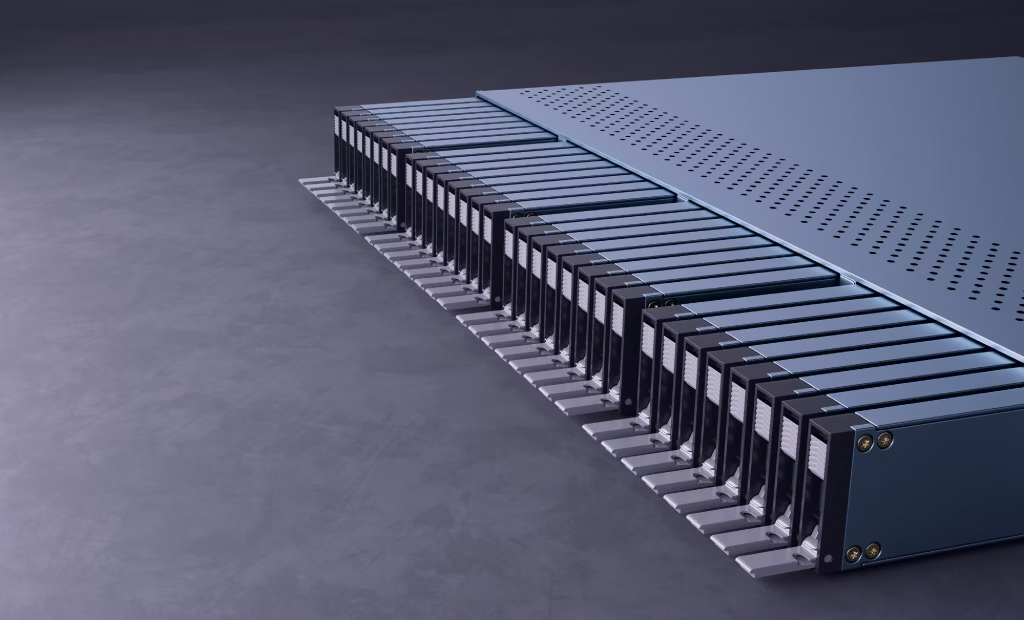

U.2 15mm フォームファクター・ドライブの場合、一般的な 2U エンクロージャーは、24 ~ 26 枚のディスクを収容でき、最大 1.44PB の容量を実現します。 E1.L 9.5mm フォームファクターへの更新により、図 1 に示すとおり、1U エンクロージャーは 32 枚のディスクに対応します。 2U では、ストレージ密度は2Uの U.2 エンクロージャーよりも約 2.6 倍高くなっています。 比較を表 2 に示します。

| フォームファクター | 2U ラックスペースの 60TB ドライブ数 | 2U ラックスペース当たりの容量 | Legacy U.2 15mm | 24 | 1.47PB | E1.L 9.5mm | 64 | 3.93PB |

|---|

表 2. ドライブ・フォームファクターに基づく2Uラックユニットの容量

注目すべきは、単一のエンクロージャーにおける高いストレージ密度により、ストレージ・ノードが占めるラックスペースや必要なネットワーク・ポートの数、同じ容量とマンパワーを要求される際にそれらを動作させるために必要な電力、冷却、スペアパーツが大幅に削減されることです。

2. データ共有機能

前述した複数のチームの共同作業と、配信前により多くのデータをトレーニングしたいという願望を考慮して、ストレージのデータ共有機能は最も重要なものです。 これは、ストレージ・ネットワークの高い IOPS、低レイテンシー、帯域幅に反映されています。 さらに、ネットワーク・コンポーネントの故障が発生してもネットワーク・サービスが動作し続けるためには、マルチパスのサポートが不可欠です。 時間が経つにつれて、既存のネットワークはイーサネットと InfiniBand に統合されました。 InfiniBand は、豊富なデータレート、優れた帯域幅とレイテンシー・パフォーマンス、RDMA ネイティブサポートを備えています。 その結果、InfiniBand は、AI ストレージをサポートする強力なネットワークとなっています。 現在、最も人気のあるイーサネット帯域幅は、25Gbps、40Gbps、100Gbps です。 。NVIDIA には、200Gbps および 400Gbps を低レイテンシーでサポートする製品もあります。 ネットワーク・ストレージ間の東西データフローでは、ノードはストレージ VLAN を備えています。 NVIDIA には、200Gbps および 400Gbps RDMA をサポートする製品もあります。

3. さまざまなI/Oへの適応性 AI ストレージのパフォーマンスは、あらゆるタイプのI/O操作で一貫している必要があります。 すべてのファイルとオブジェクトは、1KB の小さなアイテムラベルでも、50MB の画像であっても、TTFB (time-to-first-byte, 最初の 1 バイトまでのアクセス時間)が一貫したままであることを保証するために、ほぼ同じ時間でアクセスできる必要があります。

4. 並列ネットワークファイル操作 AI プロジェクトでは、バルクコピー、列挙、プロパティの変更などの一般的なタスクで、効率的な並列ネットワーク・ファイル操作が要求されます。 これらの操作は、AI モデル開発を大幅に促進します。 元々1984年にSun Microsystemsによって開発された、NFS (Network File System) は、現在でも最も主要なネットワーク・ファイルシステムのプロトコルです。 NFS over Remote Direct Memory Access (NFSoRDMA) は特に、大量のデータを転送するコンピューティング集約型のワークロードに適しています。 RDMA のデータ移動オフロード機能により、不要なデータコピーが削減され、効率が向上します。

5. AI ストレージの主な特性のまとめ AI ストレージ・ソリューションでは、十分な容量、堅牢なデータ共有機能、さまざまなI/Oタイプで一貫したパフォーマンス、並列ネットワークファイル操作のサポートを提供する必要があります。 これらの要件は、AI プロジェクトが成長しているデータセットを効果的に管理し、AI モデル開発と導入のパフォーマンス要件を満たすことを保証します。 最後に AI 開発は、私たちが抱いている大きな期待を上回り続けています。 巨大計算企業に高速でより多くのデータを処理することを緊急に求められているため、アイドル処理時間と消費電力の余地はありません。 ソリダイムは、さまざまな AI 導入のニーズを満たすために、さまざまなフォームファクター、密度、価格帯のドライブを提供しています。 高密度QLC SSDは、パフォーマンス、容量、信頼性、コストの優れた点を証明されています。

図 1. TLC のみのソリューションを SLC/TLC+QLC に移行

CSAL とソリダイム D7-P5810 SLC SSD を組み合わせることで、お客様はパフォーマンス、コスト、容量で導入を調整できる機能を利用できます。1 革新的な完全なスタックとオープンソース・ストレージ・ソリューションにより、ソリダイム SSD が AI ストレージの進歩を促進するユニークな利点を持っていることは明らかです。

図 2. CSAL アーキテクチャー

著者紹介

Sarika Mehta は、ストレージ業界で 15 年以上のキャリアを持つ、ソリダイムのストレージ・ソリューション・アーキテクトです。 ソリダイムの顧客やパートナー企業との緊密な連携を通じ、コストとパフォーマンスを両立するストレージ・ソリューションの最適化に注力しています。

Wayne Gao は、ソリダイムのストレージ・ソリューション・アーキテクトにおけるプリンシパル・エンジニアです。 Wayne は、Pathfinding から Alibaba の商用リリースまで CSAL の研究開発に取り組んできました。

Wayne は、Dell EMC ECS オールフラッシュ・オブジェクト・ストレージ・チームの一員として、20 年以上のストレージ開発経験を持つほか、4 件の米国特許出願/助成金を受け、EuroSys の論文著者でもあります。

Yi Wang は、ソリダイムのフィールド・アプリケーション・エンジニアです。 ソリダイム入社前は、インテル、Cloudera、NCRで技術職を歴任しました。 「Cisco Certified Network Professional」、「Microsoft Certified・Solutions Expert」、「Cloudera Data Platform Administrator」の認定を受けています。

注

[2] https://www.solidigmtechnology.com/products/technology/solidigm-ssds-in-superpod-ai-storage-nvidia-vast-data.html