推論コンテキストメモリストレージプラットフォーム(ICMSP):AI推論がフラッシュ問題になりつつある理由

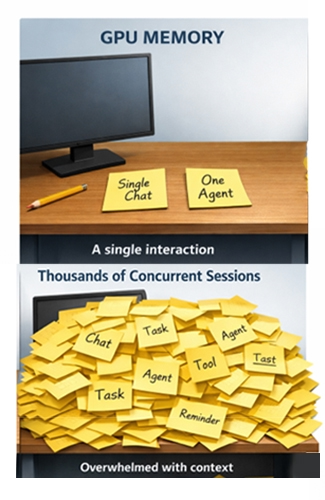

現代のAIシステムはプロセッサの近くで保持するよう設計されたものよりもはるかに多くのコンテキストを保持するため、推論は新しいメモリウォールに直面しています。AIがワンショットプロンプトから長時間の会話やエージェントワークフローに移行するにつれ、推論のメモリフットプリントは急速に拡大しています。 これにより、インフラストラクチャスタックに新たなボトルネックが発生します。

数千もの対話型アプリケーション、アシスタント、自律型エージェントを同時に処理するGPUラックを想像してみてください。それぞれのやり取りは、それ自体は軽いものに見えるかもしれませんが、それらが組み合わさることで「ワーキングメモリ」が蓄積され、一貫性のある効率的な応答を維持するためにこれを保存する必要があります。

このワーキングメモリはキー値(KV)キャッシュに格納されます。KVキャッシュは、以前に計算されたキー/値のペアを保存して生成時に再利用し、冗長な計算を回避します。1

コンテキストがGPUに最も近いメモリ層に収まらなくなった場合、パフォーマンスが低下します。レイテンシーが増加します。スループットが低下します。また、データセンターで最も高価なハードウェアの一部がアイドル状態になり始めます。

NVIDIAのCEO、ジェンスン・フアン氏がCES 2026のNVIDIA Liveで紹介したように、NVIDIAの推論コンテキストメモリストレージプラットフォーム(ICMSPまたは略称「ICMS」)では、ポッドレベルのフラッシュバックコンテキスト層を、ラックスケールで共有および再利用できるAIネイティブKVキャッシュレイヤーとして位置付けています。2,3,4

推論メモリウォール

過去10年間の大半において、AIインフラストラクチャに関する議論はGPUのデータ供給に集中していました。時間の経過とともに推論ワークロードが進化するにつれて、その焦点はコンテキストがどのように蓄積されるかに移りました。モデルの能力が高まるにつれ、推論は破棄するのではなく、状態を保持するものとなってきました。

KVキャッシュはパフォーマンスに不可欠ですが、一度に複数の次元に沿って拡張されます。

- コンテキストウィンドウが長いほど、各セッションのキャッシュサイズが大きくなります。

- 同時実行性が高まると、ユーザー全体のフットプリントが倍増します。

- エージェントワークフローはセッションの寿命を延ばし、単一のプロンプトと応答の交換よりもはるかに長い時間、コンテキストをアクティブに保ちます。

その結果、推論サービスではコンピューティング能力が制限されるかなり前にメモリが制限される可能性があります。GPUが利用可能なサイクルを持っている場合でも、コンテキストが取得または再計算されるのを待っている間に停止することがあります。この影響は、テールレイテンシーが重要でワークロードが動的に変動する実際の状況で最も顕著になります。

一般的なアプローチの1つは、データセンターで既に存在する共有ストレージシステムにコンテキストをプッシュすることです。アクティブな推論では、これにより新しいレイテンシーとトラフィックの課題が生じます。従来のファイルシステムとオブジェクトストアは耐久性と共有に最適化されていますが、トークン生成のクリティカルパスに直接配置されているレイテンシーに敏感な読み取りには最適化されていません。KVトラフィックがネットワーク上を縦方向に移動するにつれ、レイテンシーは予測不能になり、輻輳が増加します。

KVキャッシュは、メモリのような応答性とともにストレージスケール容量を必要とします。NVIDIAのICMS/ICMSPコンセプトはまさにそのギャップを埋めることを目的としています。3,4

NVIDIAの推論メモリ階層におけるG3.5コンテキスト層

NVIDIAは、推論コンテキストメモリストレージプラットフォームについて、NVIDIA BlueField-4 データプロセッサを使用してポッドレベルで動作する専用のコンテキストメモリ層を作成し、高速GPUメモリとスケーラブルな共有ストレージのギャップを埋めることを目的とした、完全に統合されたストレージインフラストラクチャであると説明しています。 3,4

NVIDIAの技術説明では、これにより新しい「G3.5」レイヤーが導入されます。これはKVキャッシュ用に特別に最適化されたイーサネット接続フラッシュ層で、共有、進化、マルチターンエージェントコンテキストに十分な大きさがあり、デコードが停止することなくGPU/ホストメモリに頻繁にプリステージングできるほど近くなるように設計されています。 3

実際に、NVIDIAはICMS/ICMSPを派生した推論状態(本質的に一時的なもの)に最適化されたラック/ポッドローカルフラッシュ層として位置付けています。コンテキストブロックは、各ノードで同じ履歴を個別に再マテリアライズすることなく、サービス間で保存、再利用、オーケストレーションすることが可能で、必要に応じて上方にステージバックできます。 3

図1. アクティブ参照向けのICMSPの新たな階層

図1. アクティブ参照向けのICMSPの新たな階層

概念的には、これによりGPU HBMとデータレイクの間に中間層が生成されます。既存のストレージシステムを置き換えるものではありませんが、アクティブな推論状態を処理する方法と場所が変更されます。

推論インフラストラクチャのセグメンテーションモデル

ICMS/ICMSPを理解する1つの方法は、推論インフラストラクチャを3つの異なるゾーンとして見ることです。

コンピューティングノード

GPUに最も近いのはコンピューティングノードで、HBM、システムメモリ、ローカルSSDの即時ワーキングセットを保持します。ここでトークンが生成され、レイテンシー感度が最も高くなります。

ポッドローカルコンテキスト層

さらに、ICMS/ICMSPポッドローカルコンテキスト層もあります。このレイヤーは、GPUメモリの近くに恒久的に残るには大きすぎる推論状態を保持しますが、迅速かつ予測可能な方法でアクセスする必要があります。 NVIDIAはこれを、Spectrum-X Ethernetと組み合わせることで、予測可能で低レイテンシーかつRDMAベースのアクセス特性を持つポッドレベルのコンテキスト層であると説明しています。 3,4

データレイク

ポッドの向こう側にはデータレイクがあり、モデル、データセット、ログ、アーティファクトを記録する永続的なシステムとして機能します。この層は必須ですが、トークンごとの応答性のために設計されたものではありません。ICMS/ICMSPは、主に耐久性を目的として設計されたストレージインフラストラクチャにレイテンシーに敏感なKVデータをプッシュする圧力を減らすことで、データレイクを補完します。 3

このモデルに対応するには容量だけでは不十分です。ポッドスケールで推論コンテキストを効率的に管理する方法が必要になります。

図2. GPUポッド KVキャッシュ

図2. GPUポッド KVキャッシュ

ICMS/ICMSPにおけるDPUの役割

ICMS/ICMSPは、推論コンテキスト専用の処理レイヤーを導入することで、SSD容量の追加を超えて拡張されます。NVIDIAの公開資料では、このプラットフォームはNVIDIA BlueField-4データプロセッサを搭載し、Spectrum-X Ethernetとペアリングして、KVキャッシュデータへのRDMAベースの効率的なアクセスを支援することが強調されています。 3,4

NVIDIAはさらに、BlueField-4がハードウェアアクセラレーションによるKVキャッシュ配置を可能にし、メタデータのオーバーヘッドとデータ移動を削減する一方で、Spectrum-X EthernetはAIネイティブのKVキャッシュにアクセスするための高性能ファブリックとして機能すると説明しています。4

以上をまとめると、NVIDIAが説明するアーキテクチャの選択は、コンテキスト処理をGPUに近づけ、より決定的なものにするために設計されており、推論負荷下でのコンテキスト待機に費やされるストールと時間を削減するものとなっています。

推論メモリのサイズを決定する新しい方法

ICMS/ICMSPの最も重要な影響の1つは、推論インフラストラクチャにおける容量プランニングがどのように進化するかです。推論コンテキストは、各アクセラレーターに接続された固定容量のメモリではなく、ラックスケール/ポッドスケールのリソースになります。

NVIDIAの技術説明によると、G3.5層は推論コンテキスト用にGPUポッドあたりの共有容量をペタバイト単位で提供し、従来の共有ストレージよりもかなり近い(そしてレイテンシーが低い)状態で、HBM/DRAM/ローカルSSDを超えて階層を拡張します。 .3

これにより、推論のための新たな「フラッシュ乗数」が導入されます。GPUのデプロイメントにより、ポッド内(またはポッドのすぐ隣)にデプロイする高密度かつ電力効率の高いSSDに対する需要が高まっています。

ICMSPクラスのシステムとは

初期のICMSPクラスのシステムは、使い慣れたストレージビルドブロックに似ていますが、用途が異なります。「新しい目的」はコンポーネントそのものではなく、一般的なアプリケーション用のファイル/オブジェクトを提供するのではなく、メモリのような応答性と予測可能な動作でKVキャッシュコンテキストを提供するという要件です。3,4

- 高密度のNVMeシェルフは、大規模なプールフラッシュ容量を提供します。

- DPU(NVIDIAではこの実装をBlueField-4と説明しています)はこれらのフロントエンドとして機能し、コンテキスト配置とデータ移動機能を処理します。 3,4

- 高帯域幅、低レイテンシーのEthernet(NVIDIAはSpectrum-X Ethernetを強調)がこの層をポッドの残りの部分に接続します。3,4

ハードウェアの観点から見ると、これは、たとえ役割が変わっても、よく知られているインフラストラクチャのように見えます。 システムはファイルやオブジェクトを提供する代わりに、負荷がかかっても予測可能な動作で派生した推論コンテキストを保存・提供します。

コンテキストメモリの必要性を促進するワークロード

ICMS/ICMSPの需要は、現代の推論を形作るものと同じワークロードによって促進されています。エージェントシステムは、監視、計画、行動、反映のループで動作し、コンテキストを1つの応答よりもはるかに長く維持します。長いコンテキスト推論は、モデル自体がGPUメモリに十分に適合している場合でも、KVキャッシュを増加させます。同時実行性の高いデプロイメントでは、テール動作と予測可能性が、純粋なスループットと同じくらい重要になります。

このような環境では、コンテキストが第一の容量検討要因となります。

ICMSPがSSD要件に及ぼす影響

フラッシュをコンテキストメモリとして扱うことで、購入者が最適化を求める対象が変わります。ポッドの領域は限られており、GPU数に応じてコンテキストが拡大するため、密度が重要になります。AIファクトリーはスペースだけでなく、ワット数によっても制約されるため、電力効率は重要です。読み取り速度が遅いとGPUがアイドル状態になるため、予測可能なレイテンシーとサービス品質も重要になります。

耐久性はコンテキストの動作とも整合させる必要があります。KVを大量に再利用するワークロードもあれば、セッションの作成と削除に応じて積極的に変動するワークロードもあります。外部のKVキャッシュ層に依存する推論アーキテクチャでは、ピークベンチマークパフォーマンスよりも、実環境の持続的な条件下でのSSDの動作が重要になります。

コンテキストオフロード時代に適合するSolidigm

Solidigm™にとって、ラックローカルコンテキスト層の出現は、あるシンプルなアイデアを裏付けるものです。すなわち、推論がより持続的でマルチターンになるにつれて、コンテキストへのアクセス可能性、予測可能性、コスト効率を大規模に維持するために、大容量フラッシュがますます重要になるというものです。

Solidigmは、この動向を設計スペースの両端にマッピングするSSDで支援しています。

- レイテンシーのヘッドルームがタイトな場合でもパフォーマンスを最大化: Solidigm™ D7-PS1010は、高スループットと実環境のIO条件に対応するように設計されたPCIe Gen5SSDオプションです。

- ラックあたりのテラバイト数が支配する最大密度: Solidigm™ D5-P5336 SSDは非常に高い容量(最大122TB)を備え、制約のあるラック/電力エンベロープ内の密度を最大化します。

要件が成熟するにつれて、適切なSSDの選択は、KVライフサイクルのどの程度が再利用で、どの程度が変更によって占められるか、さらには、レイテンシー要件が規模に応じてどの程度厳格に適用されるかによって決まります。

ドルとワットで表した値

NVIDIAはICMS/ICMSPコンセプトの具体的なパフォーマンス/効率性を公表しています。たとえば、NVIDIAはその発表資料で、「従来のストレージ」と比較して毎秒最大5倍のトークン数と最大5倍の電力効率の向上(ベースライン/ワークロードによる)を実現すると主張しています。 2,4

実際には、コンテキスト層の価値が際立つのは、固定されたレイテンシーターゲットにおいてストールの削減、利用率の改善、同時実行性の向上を実現させた場合です。 こうした効果は、GPU時間がストレージ容量よりもはるかに高価であるため、配信されるトークンあたりのコストの削減に直接つながります。

全体像

ICMS/ICMSPはAIインフラストラクチャの方向性を示すものです。すなわち、推論効率を中心に、コンピューティング、ネットワーキング、ストレージが共同設計されるラックスケールシステムに向かっています。 推論がより持続的でエージェント的になるにつれて、GPUに近いメモリを超えて拡大するコンテキストをシステムがどのように上手く処理するかが、中心的な課題となります。

そして多くの場合、メモリが不足する場所にフラッシュを配置し、ポッドの一部のように動作するのに十分近い場所に保つことが、解決策となっています。このパターンが広がるにつれて、ストレージはAI推論の経済性を形作る主要な手段の1つになります。

このような環境において、ストレージは受動的な容量から積極的なインフラストラクチャへと移行します 推論コンテキストにフラッシュを選択するには、持続的な実環境の負荷下での密度、電力効率、および予測可能な動作に細心の注意を払うことが必要です。

Solidigmは、AIインフラストラクチャ構築者と協力して、こうした新たな要件にフラッシュ技術を整合させることにより、推論の規模が拡大しても推論コンテキストへのアクセス可能性、効率性、費用対効果を維持できるよう支援しています。 詳しくは、www.solidigm.comをご覧ください。

著者について

ジェフ・ハートホーンは、SolidigmのAIデータインフラ担当マーケティングアナリストです。ソリューション・アーキテクチャー、製品企画、マーケティングの実践経験を活かし、水冷式E1.S SSDの競合調査など、企業向けAIメッセージングの策定に携わり、専門家レベルの詳細を顧客や協力パートナーのための鮮明なビジネス価値に変換しています。学位は、カリフォルニア州立大学サクラメント校でコンピューターエンジニアリングの理学士号を取得しています。

出典

- NVIDIA TensorRT-LLMドキュメント(KVキャッシュの定義/動作): https://nvidia.github.io/TensorRT-LLM/latest/features/kvcache.html

- NVIDIAブログ(CES の要約、2026年1月5日):「NVIDIA Rubinプラットフォーム、オープンモデル、自動運転...」 https://blogs.nvidia.com/blog/2026-ces-special-presentation/

- NVIDIAのテクニカルブログ(2026年1月6日):「NVIDIA BlueField-4搭載の推論コンテキストメモリストレージプラットフォームの導入...」 https://developer.nvidia.com/blog/introducing-nvidia-bluefield-4-powered-inference-context-memory-storage-platform-for-the-next-frontier-of-ai/

- NVIDIAのニュースルーム/プレスリリース(2026年1月5日):「NVIDIA BlueField-4がAIネイティブストレージインフラストラクチャの新しいクラスを強化...」 https://nvidianews.nvidia.com/news/nvidia-bluefield-4-powers-new-class-of-ai-native-storage-infrastructure-for-the-next-frontier-of-ai