SSD オフロード技術で実現する AI スケーリング

メモリ使用量を 57% 削減して、クエリ速度を 50% 向上? そんなうまい話、信じられますか?

今、検索拡張生成(RAG)による AI 推論は、まるでウッドストック音楽祭のような熱狂を迎えています

1969 年、伝説となったウッドストック音楽祭の当初の想定来場者数は約 5 万人にすぎませんでした。しかし、ジミ・ヘンドリックス、ジャニス・ジョプリン、ザ・フーといった豪華な顔ぶれに加え、カウンターカルチャーのうねりが絶妙に重なったことで、会場となったニューヨーク州ベセルの酪農場には実に約 50 万人もの人々が押し寄せました。結果として、多くの参加者が体験したのは、音楽よりも食糧不足、衛生問題、そして泥だらけの環境でした。

RAG による推論はビジネス課題を解決するうえで非常に強力かつ魅力的な手法であるため、現在、多くの企業がこぞって導入を進めています。もちろん、必要なインフラが整っていなければ、ユーザー体験の質が下がったり、そもそも利用できなかったりといった問題が生じ、せっかくの技術が持つポテンシャルを十分に引き出せません。

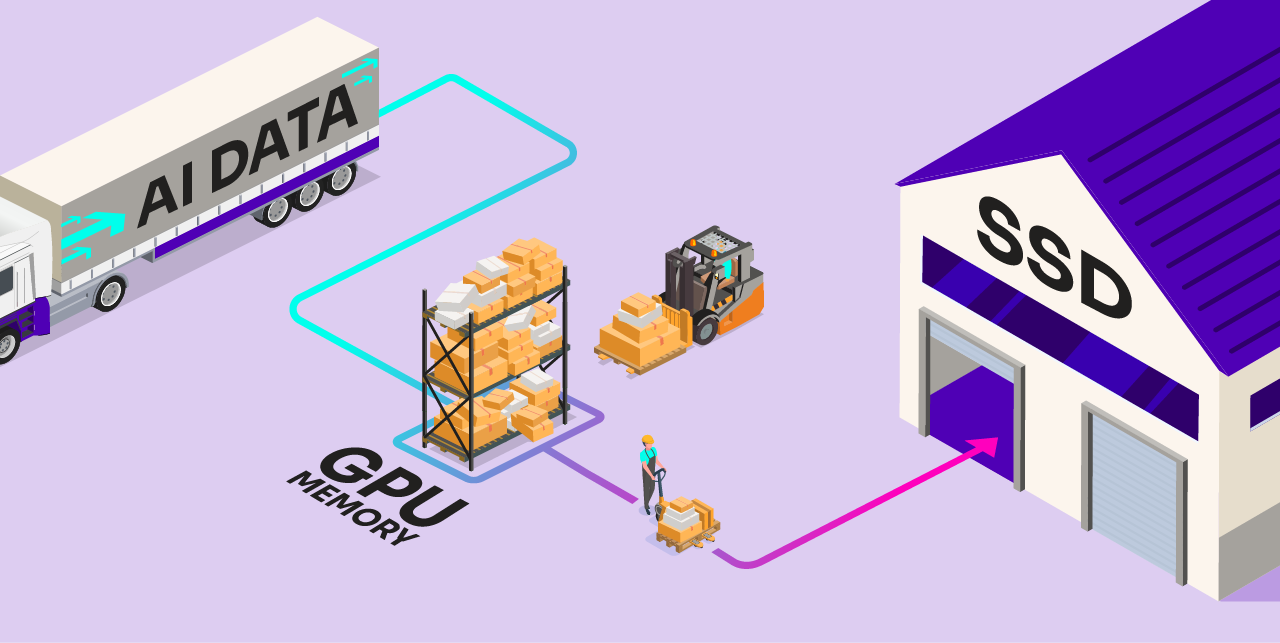

いま求められているのは、前例のないスケーラビリティとコスト効率を両立できる新しいアプローチです。そこで、Solidigm と Metrum AI による画期的な研究成果をご紹介したいと思い、筆をとった次第です。今回ご紹介する戦略を活用すれば、AI モデルの重みや RAG データといった大量のデータを高価なメモリから高性能な SSD へとオフロードすることで、かつてない水準で AI の価値を引き出せるようになります。

Metrum AI の CEO、スティーン・グラハム氏は次のように述べています。「私たちは、最先端の視覚言語モデルと大規模言語モデルを活用し、文脈に即した豊かな要約を生成する、ビデオ解析向けの高度な RAG ソリューションを開発しました。このソリューションを Solidigm D7-PS1010 SSD 上に展開し、DiskANN を統合することで、高速かつメモリ効率に優れたベクトル検索を実現しました。その結果、パフォーマンスを維持したまま、メモリ使用量の最適化にも成功しています」

私たちのアプローチや主な調査結果については、ぜひ以下をご覧ください。また、ホワイトペーパー『SSD オフロードによる TCO 最適化された高性能 RAG』もダウンロードいただけます。さらに、「自分で検証してみたい」という方のために、すべての内容を GitHub リポジトリで公開中です。ぜひお試しください。

RAG とは?なぜいま注目されているのか?

簡単な例で説明しましょう。たとえば、AI チャットボットに「海外旅行に必要な書類は何ですか?」と質問したとします。もしその AI が、トレーニングデータとして十分で正確な情報を持っていれば、有益な答えを返してくれるでしょう。

しかし、そうでない場合、次のような 2 通りの結果が考えられます。1.「分かりません」と答える。2. もっと悪いことに、自信たっぷりに間違った答えを返す。後者の現象はハルシネーション(幻覚)と呼ばれており、思っている以上によく起こります。

AI の価値は、モデルがアクセスできるデータの「量」と「質」に大きく左右されることは明らかです。

ここで登場するのが、検索拡張生成(RAG)です。その名のとおり、RAG は応答を生成する前に、関連性の高い追加データを検索し、モデルの知識を補強・拡張します。これは、もともとの学習データには含まれていない外部データソースに AI モデルを接続することで実現されます。たとえば、社内のデータベース、ニュースフィード、さらにはウィキペディアなど、ほぼどんな情報源でも利用可能です。先ほどの例で言えば、旅行に関するユーザーの質問は、まずそうした情報源に送られ、関連情報が取得されたうえで AI モデルに渡されます。その結果、より的確な回答が得られる可能性が高まるのです。

RAG の 2 大メリット

- モデルに新たなデータを追加するために、継続的に再トレーニングを行う必要がなくなる。

- 従来の公開トレーニングデータよりも新しく、信頼性が高く、具体的な情報を参照できるようになる。

巨大なコンテキストウィンドウを備えた新しいモデルの登場により、RAG はもう必要ないのでは?という議論が注目を集めています。たとえば、Meta の Llama 4 Scout は、1000 万トークンという大規模な入力に対応しています。このようなモデルでは、あらかじめすべての関連情報をプロンプト内に盛り込むことができるため、外部データソースに接続する必要がないという主張もあります。

一見するともっともらしい議論ですが、それが現実に成り立つかどうかはまだ疑問です。実際、2025 年 3 月に発表された研究論文では、こうした大規模コンテキストモデルのリコール(応答の正確性)を検証した結果、「表面上は数百万トークンを扱えるとされていても、実際に活用できるのはそのごく一部であり、ほとんどのケースで 2,000 トークンを超えるとリコールが低下する傾向がある」といった事実が明らかになっています。

問題は何か?

企業が RAG を活用した推論を急速に導入している理由は、ここまで読んでいただければお分かりいただけたと思います。そして問題は、50 年以上前にウッドストック音楽祭の主催者が直面した状況とよく似ています。急激に、そして大量に、ユーザーからの需要が高まっているのです。

具体的に、企業が求めているのは次の 2 点です。

- より大きな RAG データセット:AI モデルが扱えるデータの量と質をさらに高めたい

- より複雑なモデル:データを処理し、高品質なインサイトを得たい

どちらも悪い目標ではありません。しかし問題は、いずれも膨大なデータを必要とし、それをどこかに保存しなければならないという点です。現在の一般的な状況では、RAG データやモデルの重みはメモリ上に保持されており、このやり方では非常に高額なコストがすぐに発生してしまいます。

SSD オフロードアプローチの導入

Solidigm は Metrum AI と連携し、まったく新しいアプローチを切り拓きました。それが、「SSD オフロード」という手法です。このアプローチでは、慎重に選定・微調整されたオープンソースのソフトウェアコンポーネントを連携させ、AI 推論中にメモリから SSD に大量のデータを移動させます。

ここには 2 つの重要な要素があります。

- RAG データのオフロード:DiskANN(大規模なベクトルデータ検索用のアルゴリズム群)を使用することで、RAG データセットの一部を SSD に再配置できます。この方法の最大のメリットは、コスト効率を保ったまま、はるかに大規模なデータセットを扱えるようになることです。

- モデルの重みのオフロード:Ray Serve と DeepSpeed を併用することで、AI モデルそのものの一部を SSD に配置できます。主なメリットは、GPU メモリの使用量を抑えつつ、より複雑なモデルや複数モデルの同時稼働が可能になることです。たとえば、通常であれば約 160GB のメモリを必要とする 700 億パラメータのモデルを、ピーク時の使用量をわずか 7~8GB に抑えて実行できることが実証されています。

主な調査結果

1. DRAM 使用量の削減

図1. SSD オフロードの有無による DRAM 使用量の比較(少ないほど良好)

図1. SSD オフロードの有無による DRAM 使用量の比較(少ないほど良好)

AI データをメモリから SSD にオフロードする最大の利点は、当然ながら、メモリ使用量の削減にあります。私たちは、オープンソースのデータベース向けベンチマークツール VectorDBBench を使用し、100 万から 1 億ベクトルまで、段階的にサイズが増加する 3 つのデータセットを用いて効果を測定しました。

結果として、データベースが大きくなるほど、削減効果も大きくなることが確認されました。つまり、扱うデータ量が増えるほど、メモリの節約効果が高まるということです。最大規模のデータセットにおいては、DRAM 使用量が 191GB 減少し、57% の削減が見られました。これは、現在のメモリ価格を考慮すると非常に大きなコスト削減につながります。

2. クエリ速度の向上

図2. SSD オフロードの有無による 1 秒あたりのクエリ数(QPS)の比較(多いほど良好)

図2. SSD オフロードの有無による 1 秒あたりのクエリ数(QPS)の比較(多いほど良好)

データをメモリから SSD に移動することで、1 秒あたりのクエリ数(QPS)で測定される処理性能が向上しました。中規模のデータセットでは最大 70%、最大規模のデータセットでは 50% の QPS 向上が確認されています。つまり、より少ないメモリでより高速な推論が可能になるということです。

この結果は、直感に反しているように思われるかもしれません。通常、ストレージから読み出すよりもメモリの方が速いはずだ、と考える方もいるでしょう。しかし、私たちはこの数値を三重に検証しました。デフォルトのパラメータ設定で構成した場合、DiskANN は従来のインメモリ方式である HNSW よりも高い QPS を実現しています。DiskANN に採用されている Vamana のようなインデックス作成アルゴリズムは、事前処理を多く行い、ベクトルを SSD に効率よく格納することで、類似検索を大幅に高速化することができます(インデックス作成については後述)。

なお、Solidigm の検証では、HNSW でも特定のパラメータを調整することでパフォーマンス向上を実現できましたが、その代償としてメモリ使用量がさらに増加する結果となりました。

3. トレードオフ:構築時間の増加

図3. SSD オフロードの有無によるインデックス作成時間の比較(短いほど良好)

図3. SSD オフロードの有無によるインデックス作成時間の比較(短いほど良好)

タダほど高いものはないとよく言われますが、この場合にも当てはまります。SSD オフロードアプローチを使用した場合、RAG インデックスの構築にかかる初期時間は 30~60% 長くなります。

とはいえ、あらかじめ手間をかけておけば、スタックを展開した後の継続的なパフォーマンス向上という大きなメリットが得られます。

ユースケースによっては、この構築時間の長さが導入の障壁になるかもしれません。しかし多くの場合、メモリ使用量の削減や QPS の向上といった恩恵が、それを上回る価値をもたらします。結局のところ、インデックス作成は一度きり、あるいはごくまれにしか発生しない処理であり、モデルを使ってインサイトを生成する頻度と比べれば微々たるものです。

4. 高いリコール

図4. SSD オフロードの有無によるリコールの比較(高いほど良好)

図4. SSD オフロードの有無によるリコールの比較(高いほど良好)

最後に、リコール(=モデルの出力精度)について補足します。SSD オフロードアプローチと従来アプローチを比較したところ、両者のリコール率に有意な差は見られませんでした。どちらもリコールはほぼ 100% を記録しています。つまり、データを SSD にオフロードしても、出力の質が損なわれることはないということです。

まとめ

今回ご紹介したのは、私たちが実際に測定・検証した結果に基づく内容です。限られたコストで大量のデータを推論パイプラインに取り込みたい企業にとって、今回のアプローチは大きな価値をもたらすと、私たちは確信しています。たとえば、RAG データを SSD にオフロードすることで、より大規模なデータセットに、より低コストでスケーリングすることが可能になります。さらに、モデルの重みをオフロードすることで、GPU メモリの制約が厳しい従来のハードウェアやエッジ環境でも、ソリューションを柔軟に展開できるようになります。

とはいえ、私たちの言葉を鵜呑みにする必要はありません。ぜひ、こちらの GitHub リポジトリをご覧ください。以上の結果を実際に再現できるすべての情報を公開しています。さらに詳しいデータや測定手法については、ホワイトペーパー『SSD オフロードによる TCO 最適化された高性能 RAG』をご確認ください。

著者紹介

エース・ストライカーは、Solidigm のマーケット開発担当ディレクターです。同社のデータセンターストレージソリューションポートフォリオの新たな用途にフォーカスしています。

注

この記事は、Data Center Frontier に掲載されたものです。

掲載されているデータやグラフの出典については、ホワイトペーパー『SSD オフロードによる TCO 最適化された高性能 RAG』をご確認ください。

本資料に記載した内容はすべて、明示されているか否かにかかわらず、いかなる保証を行うものでもありません。ここにいう保証には、商品適格性、特定目的への適合性、および非侵害性の黙示の保証、ならびに履行の過程、取引の過程、または取引での使用から生じるあらゆる保証を含みますが、これらに限定されるわけではありません。

本書で説明されている製品には、「エラッタ」と呼ばれる設計上の不具合が含まれている可能性があり、公表されている仕様とは異なる動作をする場合があります。現在確認済みのエラッタについては、Solidigm までお問い合わせください。

Solidigm は、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にしてデータの正確さを評価してください。

製品をご注文される前に最新の仕様をご希望の場合は、Solidigm の担当者または販売代理店にお問い合わせください。

SOLIDIGM および Solidigm の「S」のロゴは、米国、中華人民共和国、日本、シンガポール、欧州連合、英国、メキシコ、およびその他の国で登録されている、SK hynix NAND Product Solutions Corp(商号Solidigm)の商標です。