DPUネイティブの分散型フレキシブルストレージソリューション

AIインフラにおける高密度QLC SSDの台頭

人工知能が私たちの世界に浸透する中で、これまでほとんど活用されていなかったアーカイブデータから新たな知見を引き出せるようになりつつあります。その結果、かつては「コールド」ティア、または休眠中とみなされていたストレージ層が「ウォーム」ティアになり始め、その膨大な履歴データのリポジトリを活用して学びを得るための新しい競争が激化しています。これまではハードディスクドライブ(HDD)がアーカイブストレージのバックボーンとして、こうしたコールドティアの要件に十分対応してきました。しかし、AIモデルやGPUワークロードを動かすためのデータへのアクセスが増加するにつれて、HDDの限界が明らかになってきました。

HDDのパフォーマンスは、もはや急速なデータ抽出と配信の要求に追いついていません。また、HDDがデータ密度において目覚ましい進歩を遂げているとはいえ、市場シェアを拡大している高密度クワッドレベルセル(QLC)SSDの域には達していません。QLC SSDは、ストレージ密度を高めるだけでなく、HDDと比較してラックの設置面積を大幅に削減し、電力効率も向上させます。この技術的優位性により、業界では高密度QLCドライブへの顕著な移行が進んでいます。

ソリッドステートストレージは、SLC(シングルレベルセル)からMLC(マルチレベルセル)、TLC(トリプルレベルセル)、そして現在のQLCアーキテクチャーへと、目覚ましい変遷を遂げてきました。そして連続的な進化を遂げるたびに、1つのメモリセルがより多くのビットデータを格納できるようになっています。2D平面NANDから3D積層NANDへの移行により、ストレージの機能はさらに向上しています。今日、NANDチップの積層数は通常、300層を超えています。エンタープライズ分野では、主流のシングルディスクSSDが61.44TBや122.88TBという容量を実現しています。近日中にはさらに大容量のドライブも登場する見込みであり、高性能かつ大容量のアーカイブストレージの新時代が始まろうとしています。

ハイブリッドストレージソリューションに対するQLCの優位性

図1は、50MWの電力予算で16PBのネットワーク接続ストレージ(NAS)を解決する場合の、オールQLCストレージソリューションとTLC+HDDソリューションとの比較を示しています。

図1. ストレージデバイスの種類がラックスペースと消費電力に与える影響

図1. ストレージデバイスの種類がラックスペースと消費電力に与える影響

従来のTLC+HDDハイブリッドアーキテクチャーと比較すると、オールQLC高容量アレイは、同等のストレージ容量を提供しながら、ストレージの消費電力を約90%削減します。さらに、必要なラック数が大幅に減少し、8倍のスペース圧縮を実現します。ディスクドライブの台数が減少することで、ストレージ機器全体の重量も軽くなり、データセンターの床の耐荷重要件の大幅な低減につながります。QLCアーキテクチャーは、ストレージ1テラバイトあたりのインターフェース帯域幅も大幅に増加させます。詳細と前提条件については、付録Aを参照してください。

| パフォーマンスパラメータ | 30TB Exos M HDD | 122.88TB Solidigm™ D5-P5336 QLC |

| 連続書き込み | 262 MB/s | 3000 MB/s |

| 連続読み出し | 275 MB/s | 7000 MB/s |

| ランダム書き込み | 350 IOPS | 19,000 IOPS |

| ランダム読み出し | 170 IOPS | 900,000 IOPS |

表1. HDDとSolidigm D5-P5336 QLC SSDのパフォーマンス比較

表1は、30TB HAMR HDD1とSolidigm D5-P5336 122.88TB QLC SSD2の読み出し/書き込みパフォーマンスを比較しています。一般に、QLC SSDはHDDよりも大幅に読み出し/書き込みが速く、はるかに高い密度を実現します。ペタバイト規模のストレージを展開する最新のAIデータセンターやクラウドデータセンターでは、オールQLCフラッシュアレイが提供するテラバイトあたりの帯域幅がHDDベースのアレイよりもはるかに大きくなります。つまり、フルフラッシュアレイでは同じサイズのデータブロックの読み出しに要する時間が大幅に短縮されることになり、その結果、ストレージインフラがGPUに追いつき、GPUのアイドルタイムを削減できます。

大容量SSD DRAMのサイズの課題

QLC SSDには多くの利点があります。しかし、QLCの容量が大きくなるにつれて、間接ユニット(IU)のサイズも徐々に大きくなり、従来の4Kから16K、そして64Kへと増えています。これは、エンタープライズグレードのSSDコントローラーのDRAMサイズには電力予算による制限があり、DRAMは通常、論理アドレスを物理アドレスにマッピングするフラッシュ変換層(FTL)テーブルの保存に使用されるためです。ディスク容量の増加に伴い、FTLのエントリーの数も増えて、より多くのDRAMスペースが必要になります。これは、コストと実装に関する課題となります。その結果、多くのメーカーは、FTLエントリー数を減らすためにIUサイズを大きくすることを選択し、それによって、ドライブが使用するDRAMの実効容量を、より低容量のSSDと同程度に保っています。

QLC SSDのIUサイズは増加していますが、ソフトウェアスタックはこの変化に対応していません。依然として、小さな間接ユニットで設計された従来のストレージの原則に基づいて動作しています。この不適合は、潜在的に高い書き込み増幅率(WAF)につながり、その結果、QLC SSDの寿命に悪影響を及ぼします。たとえば、IUのサイズが64KのSSDに、あるアプリケーションが4Kのデータブロックを書き込む必要がある場合、実際に書き込まれるデータ量は64Kとなり、小規模な書き込みではWAFが64/4 = 16となります。OSのメモリページは通常4Kサイズであるため、最適化が行われていない場合、4Kの書き込みごとにデータ量が16倍に増幅し、耐久性と速度に悪影響を及ぼします。

ストレージソフトウェアベンダー各社は、大容量IU SSDのIUサイズに適合するよう、自社のストレージスタックの最適化を進めてきました。この機能を中小企業(SME)にも提供するため、Solidigmはクラウドストレージ高速化レイヤー(CSAL)を通じて書き込み整形機能をオープンソース化し、大容量QLC SSDの導入促進を目指しています。

CSALホストベースのFTLによるIUアライメント

CSALは、高密度NANDフラッシュSSDのパフォーマンスと耐久性を最適化するために設計されたホストベースのフラッシュ変換層です。特に混成ワークロードシナリオにおいて効果を発揮します。

図2. CSALソフトウェアのシステムアーキテクチャー

図2. CSALソフトウェアのシステムアーキテクチャー

図2に示すように、CSALは階層型ストレージアーキテクチャーを採用しており、高性能ストレージメディア(Solidigm D7-PS1010など)をフロントエンドキャッシュや書き込みバッファとして利用しています。それによって、ホストからの小さなランダム書き込み操作を、基盤となる大容量QLC SSDの大きな連続書き込み操作に変換します。このプロセスでは、アプリケーション層からの小さな書き込みを、QLC SSDの間接ユニットと同等かそれ以上のブロックサイズに集約することで、IUアライメントを実現します。この変換によってWAFが大幅に低減し、フラッシュメモリの寿命が延び、レイテンシーを低減しながらスループットが向上します。

読み出し操作は、キャッシュから行われるか、QLC SSDが提供するTLC相当の高読み出し帯域幅を活用するQLCによって行われる場合があります。

ストレージの要件は、AIパイプラインの各段階に応じて大きく異なります。たとえば、AIトレーニングプロセスの間は、チェックポイントファイルなど、大量の一時データが頻繁に保存されます。この段階では、ストレージデバイスが大容量データの連続書き込み操作を大量に処理する必要があり、QLC SSDがそれに適しています。しかし、AI推論段階では、検索拡張生成(RAG)が広く採用されており、ベクトルデータベースが頻繁に使用されます。この段階では、ストレージデバイスは、多数の小さなランダム書き込み操作を処理する必要があります。

データI/Oパターンの頻繁な変化に伴う、さまざまなI/Oサイズのアプリケーションのニーズに適切に対応するため、当社はCSALを使用した、DPUネイティブの柔軟な分散ストレージソリューションを導入しています。

CSALを使用した、DPUネイティブの柔軟な分散ストレージソリューション

図3. CSALの柔軟なストレージソリューション

図3. CSALの柔軟なストレージソリューション

図3は、柔軟なストレージソリューションを実現するためにCSALをDPUにオフロードする仕組みを示しています。このサンプルソリューションでは、キャッシュドライブ用と容量ドライブ用に別々のストレージノードを用意し、ストレージとコンピューティングの分離を実現しています。

- ストレージノードは、DPUを介してNVMe-oFターゲットとして公開されます。

- CSALソフトウェアは、DPU APIを使用してDPUにインストールされます。

- CSALは、DPU DRAMなどのDPUリソースを利用して論理物理アドレス変換(L2P)マッピングを保存し、DPUコアを利用してFTLを実行します。

- DPUオフロードにより、ストレージ処理によって消費されていたホストDRAMとCPUリソースが解放されます。

- CSALは、キャッシュドライブと容量ドライブをホストから抽象化し、NVMe-oFを通じて、それらをリモートストレージとしてアプリケーションに公開します。

本項では、このソリューションの構成要素についてさらに詳しく説明します。

1. データ処理ユニット(DPU)

DPUカード上の演算リソースは、FTLのL2Pテーブル検索やユーザーデータブロックの統合など、軽量なCSALソフトウェアのストレージ演算ニーズに効果的に対応できます。また、DPUカード上のDRAMリソースは、FTLテーブルの内容の一部を保存するために使用できます。DPUカードのリソースを活用することで、CSALはホストCPUとメモリの占有を効果的に削減し、ビジネス関連サービスにより効率的に活用できるようにします。さらに、ハイエンドのDPUにストレージ処理に使用できるより大きなDRAMメモリリソースが搭載されている場合、CSALソフトウェア内の構成オプションを変更して高性能キャッシュディスクの代わりにDPU DRAMを使用し、ソフトウェア内のキャッシュ機能を実行できます。この設計により、メモリの利用と構成に柔軟性が生まれます。

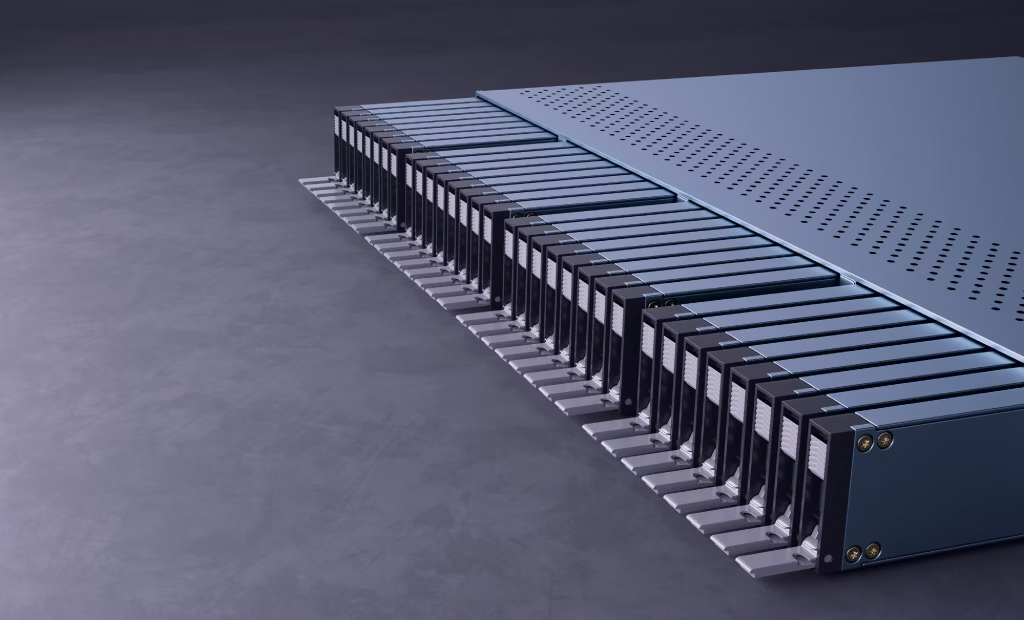

2. ストレージノード

ストレージノードは、ソリッドステートドライブを搭載したオールフラッシュアレイで構成されており、高速TLCキャッシュディスクと高密度QLC容量ディスクを組み合わせることが可能です。各ストレージノードは複数のDPUカードを搭載します。これらは、ホストにNVMe-oFベースのターゲットを提供します。ストレージノードは、ストレージネットワークに接続するためにマルチパスアクセスモードを採用します。これにより、データI/O帯域幅が向上するだけでなく、単一障害点を防ぐこともできます。

3. コンピューティングノード

コンピューティングノードサーバーは通常、コンピューティングの高い要求を満たすために、多数のGPUとDPUを搭載しています。DPUインフラは、導入初期段階であるとはいえ、普及が進んでいます。現在、DPUの処理能力は十分に活用されていませんが、多くのアプリケーションは、ホストの計算負荷を軽減するためにDPUの処理能力を活用するよう進化しています。CSALはまさにそれを実現しています。当社では、コンピューティングノードのCPUからDPUカードにCSALソフトウェアモジュールを移行しました。これにより、ネットワーク伝送時のデータ処理を高速化でき、これまでアイドル状態だったDPUリソースの活用を最大化できます。

4. ソフトウェア定義の柔軟なストレージ

DPUハードウェアを実装し、NVMe-oFプロトコルを活用することで、CSALはシングルマシンから柔軟なクロスネットワークストレージソリューションまで、幅広く対応できます。オールフラッシュアレイ(「Just a Box Of Flash(JBOF)」)ストレージノードは、ネットワーク経由で複数のNVMe-oFターゲットを提供します。データセンター管理ソフトウェアは、人工知能コンピューティングのさまざまな段階や要件に応じて、ストレージ容量や機能を柔軟に構成できます。

AIパイプラインで活用されるCSALの例

本項では、AIパイプラインのさまざまな段階でCSALストレージの柔軟性を活用する方法について、事例を通して説明します。AIコンピューティングの各段階には、それぞれ異なるIOパターンが伴います。以下の例では、CSALを活用してAIパイプラインのさまざまな段階の要件に対応する多様なボリュームを作成する方法を示します。

例1

この例では、CSAL FTLがSolidigm 122TB QLC SSDに導入されていることを前提とします。コンピューティングノードがデータ取り込みとチェックポイントフェーズ用に200TBのストレージスペースを必要とする場合、管理ソフトウェアはCSALに対し、コンピューティングノードのDPU上に2つのNVMe-oFターゲットで構成される仮想ディスクを作成するよう指示できます。この段階では大規模な連続書き込みが行われるため、キャッシュディスクは任意となります。DPUのDRAMは、ファイルシステムが発行する4Kデータブロックのごく一部を、QLC大容量ディスクに直接書き込む前に、大きな連続ブロックにマージするために利用できます。

例2

この例では、コンピューティングノードが推論サーバーであると仮定します。推論フェーズでは、読み出しと書き込みが混在するI/Oパターンが見られ、それらは小規模でランダムな性質を有しています。検索拡張生成(RAG)は推論テクニックの1つです。ベクトルデータベースはRAGシステムのコアコンポーネントです。ベクトルデータベースを保存する200TBのストレージ領域を作成するために、管理ソフトウェアは、16TBのキャッシュターゲットと2つの122TB QLCターゲットで構成されるCSAL仮想ディスクを、コンピューティングノードのDPU上に作成できます。この仮想ディスクは、ベクトルデータベースの保存に使用します。ベクトルデータベースのI/Oパターンは、小ブロックのランダム読み出し/書き込みを伴うため、キャッシュに使用される高性能ターゲットは、小規模なI/Oを間接ユニットに整列させ、後続のQLCターゲットに書き込む前に大きなデータブロックにマージする処理を行います。

DPUとCSALソフトウェアを導入することで、データセンターはすべてのストレージディスクをより効率的に活用でき、必要に応じてストレージリソースを柔軟に構成、作成、解放できます。

テストトポロジー

QLC SSDの間接ユニットへのI/Oアライメントによるパフォーマンスの向上と、DPUベースのCSALによる柔軟なストレージソリューションを実証するため、図4に示すように、当社のラボで以下のテスト環境を構築しました。

図4. CSAL+DPUテストベッド

図4. CSAL+DPUテストベッド

図4において、①と②は大容量QLCソリッドステートドライブ、③は高性能TLCキャッシュディスクです。④と⑤は、基盤となる物理ディスクをDPUネットワークとネットワークスイッチを介して結合して作成した仮想NVMe-oFディスクです。

このテスト環境では、ストレージノード上のDPUはソリッドステートドライブをNVMeターゲットに変換するために使用され、それがネットワーク経由でコンピューティングノードに公開されます。比較テストのため、①(大容量QLCソリッドステートドライブ)を独立した仮想ディスク④としてマッピングし、②と③をCSALソフトウェアを使用する仮想ディスク⑤としてマッピングしました。その後、一般的なストレージストレステストソフトウェアであるFIOを使用して、両方の仮想ディスクのストレージパフォーマンステストを実施しました。

このテストプロセスでは、さまざまな人工知能段階のブロックサイズ要件に対応するため、書き込みデータブロックサイズ、書き込みキューの深さ、書き込みパターンをさまざまな組み合わせで変化させました。たとえば、データ準備とチェックポイントのプロセスでは、テスト#1に対応する大きなデータブロックの書き込みを伴います。一方、ベクトルデータベースと書き込み事前記録アプリケーションは、テスト#4に対応する頻繁な4Kランダムデータ書き込みを伴います。テスト結果を、以下の図5に示します。

テスト結果

図5. テストデータの比較

図5. テストデータの比較

上述したテスト環境に基づき、独立した大容量QLCディスクと、高速キャッシュディスクおよび大容量QLCディスクで構成されるCSAL仮想ディスクの両方について、5つのパフォーマンステストを実施しました。その5つのテストのI/Oパターンは、人工知能コンピューティングにおける以下の異なる段階に対応しています。

データクリーニング

トレーニング時のチェックポイント

オブジェクトストレージ

書き込み事前記録

データ準備

RAG

テスト結果では、小規模な4K書き込みで、ランダム書き込みと連続書き込みのいずれにおいても、CSAL仮想ディスクは独立したQLC SSDと比較して、約20倍のパフォーマンス向上を示しています。不均一なランダム分布Zipfテストでは、ホットデータのキャッシュ効果により、CSALソリューションは独立したQLCソリッドステートドライブと比較して約15倍のパフォーマンス向上を示しました。

なお、独立したQLC SSDによる結果についても、HDDを使用する場合と比較するとはるかに優れていることにご留意ください。Gen4 QLC SSDの書き込みパフォーマンスはHDDの10倍を上回るためです。このテストは、ソリッドステートストレージの基盤となる本来的なパフォーマンスを活用できるCSALのような最新のストレージソフトウェアソリューションを使用することの重要性を示しています。AIインフラの要求を満たすと同時に、ストレージ容量の拡張性と構成の柔軟性も実現するためです。

まとめ

AIアプリケーションの増加に伴い、大量のデータを迅速にそのコンピューティング環境にとりこむため、高速かつ柔軟なストレージがAIインフラの重要な構成要素になっています。最新のAIインフラではストレージとコンピューティングの分離が提案され、推論アプリケーションではプリフィル-デコード(PD)分離が提案されていますが、いずれもストレージの柔軟性に対して高い要求を課しています。

当社のテスト結果は、AI推論アプリケーションにおいて、CSALとDPUの組み合わせがオブジェクトストレージおよびベクトルデータベースのストレージパフォーマンスおよび容量要件にシームレスに対応できることを実証しています。CSAL+DPUソリューションの目的は、大規模データセンターでストレージリソースをオンデマンドでより柔軟に割り当てられるようにして、ネットワークとストレージへの顧客投資を最大化することです。

著者紹介

Wayne Gao(ウェイン・ガオ)は、Solidigmの主任エンジニアおよびストレージソリューションアーキテクトです。Solidigmのクラウドストレージ高速化レイヤー(CSAL)に取り組み、初期の開発から商用リリースに至るまで携わってきました。Wayneは20年以上のストレージ開発経験を持ち、米国で4件の特許出願/取得実績があり、EuroSysの論文の著者でもあります。

Li Bo(リ・ボー)はSolidigmのシニアストレージソリューションアーキテクトを務めています。20年以上にわたり複数の組織でシステム設計と開発に携わり、特にネットワークおよびストレージソリューションのパフォーマンス最適化を専門としています。近年は、不揮発性ストレージ技術の業界全体への普及に力を注いでいます。

Sarika Mehta(サリカ・メヘタ)は、Solidigmのシニアストレージソリューションアーキテクトです。Intelのストレージ部門およびSolidigmでのキャリアを通じて、16年以上のストレージ経験があります。彼女はSolidigmのお客様やパートナー企業との緊密な連携を通して、コストとパフォーマンスを両立するストレージソリューションの最適化に注力しています。直接接続されたストレージから階層型および非階層型の分散ストレージソリューションまで、さまざまなストレージ導入におけるユースケースで、SolidigmのSSDのチューニングと最適化を担当しています。さらに、検証、パフォーマンスベンチマーク、パスファインディング、テクニカルマーケティング、ソリューションアーキテクチャーにおける多様なストレージの経歴があります。

注

2. https://www.solidigm.com/products/data-center/d5/p5336.html#form=U.2%2015mm&cap=122.88TB

付録A:QLCの電力効率とHDDの比較

出典:Solidigm、2024年10月。その他の情報源は下記の通り。

範囲:消費電力分析は、最先端の電力およびスペース最適化技術を活用している、新規(グリーンフィールド)ハイパースケーラー/ティア2AIデータセンターの下位レンジ実装を想定しています。主なモデルパラメータは以下の通りです。

データセンターが利用できる総電力容量を50MWと想定

各Nvidia DGX H100ラックは16,000TBのストレージ容量と組み合わせる。NetApp AI Pod with DGX H100システムリファレンスアーキテクチャーのおおよその中間値に基づく目標ストレージ容量(https://docs.netapp.com/us-en/netapp-solutions/ai/aipod_nv_architecture.html#netapp-ai-pod-with-dgx-h100-systems)

NVIDIA H100サーバーの必須IT消費電力 = 11,223W、4台のサーバーを搭載したDGX H100ラック = 44,448W

(出典 - https://www.semianalysis.com/p/ai-datacenter-energy-dilemma-race)

NVMe/HDD NASストレージの導入詳細:

a. TLC + HDD:パフォーマンス層にTLCを10%、オブジェクト層にHDDを90%の割合で導入。Supermicro A+ Server 1124US-TNRをベースとしたTLCストレージサーバー、12 x U.2容量 x 7.68TB SSD(https://www.supermicro.com/en/Aplus/system/1U/1124/AS-1124US-TNR.cfm)。Supermicro Storage SuperServer SSG-640SP-DE1CR90ベースのHDD JBOD、90 x ドライブ容量 x 30TB 3.5インチHDD(https://www.supermicro.com/en/products/system/storage/4u/ssg-640sp-de1cr90)。HDDのデューティサイクルは100%と推定。TLCアクティブ時消費電力 = 20W、アイドル時 = 5W。HDDアクティブ時10R/90W消費電力 = 9.8W、アイドル時消費電力 = 6W。冗長化アーキテクチャーはHadoopによる3重化(3xコピー)

b. オールQLC:ストレージサーバーに16%のQLC、JBOFに84%のQLCの割合で導入。Supermicro A+ Server 1124US-TNRをベースとしたQLCストレージサーバー、12 x U.2容量 x 122.88TB SSD(https://www.supermicro.com/en/Aplus/system/1U/1124/AS-1124US-TNR.cfm)。Supermicro Storage SuperServer SSG-136R-4MU32JBFを基盤としたQLC JBOF、32 x NVMeドライブ容量 x 122.88TB SSD(https://www.supermicro.com/en/products/system/storage/1u/ssg-136r-4mu32jbf)。QLCのデューティサイクルは11%と推定。QLCのアクティブ読み出し時消費電力 = 24W、アイドル時 = 5W。冗長化アーキテクチャーはRAID 1ミラーリング(2xコピー)

付録B:テストシステム構成

| テストシステム構成 | |

| システム | 製造元:AMD 製品名:AMD EPYC 7542 32コアプロセッサー |

| BIOS | ベンダー:AMD Corporation |

| CPU | AMD EPYC 7542 32コアプロセッサー |

| 1 x sockets @2.9GHz、32 cores/per socket | |

| NUMAノード | 4 |

| DRAM | 計440GiB DDR4@ 2667 MT/S |

| OS | Rocky Linux 9.6 |

| カーネル | Linux d3.d3 5.14.0-503.14.1.el9_5.x86_64 |

| SSD | 4 x Solidigm D5-P5336 15.36TB、FW Rev: 5CV10302、PCIe Gen4x4 4 x Solidigm D7-PS1010 3.84TB、FW Rev: G70YG030、PCIe Gen5x4 |

| Fio | バージョン:3.39 |

| DPU | MT43244 BlueField-3 |

表2. システム構成

付録C:参考資料

Solidigm D5-P5336仕様 https://www.solidigm.com/products/data-center/d5/p5336.html

CSAL Tech Field Dayプレゼンテーション https://www.youtube.com/watch?v=tAdQC5G0S8o

オープンソースCSALドキュメント https://spdk.io/doc/ftl.html